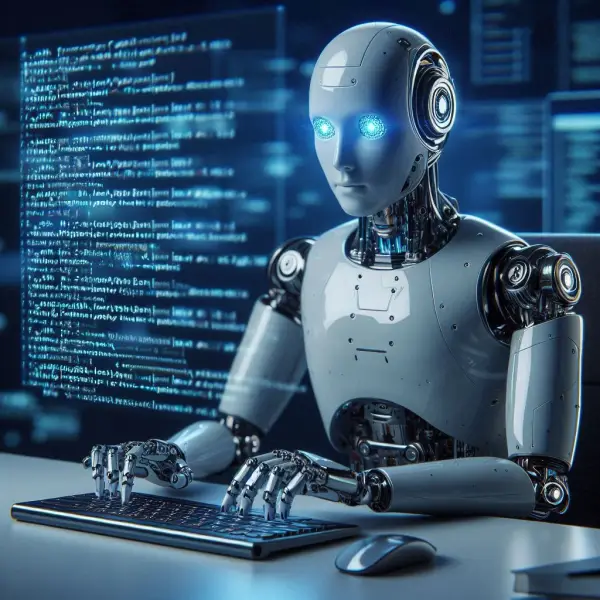

Bolehkah AI Runtuh? Pakar Memberi Amaran Mengenai Bahayanya dan Penyelesaiannya

Mengapa AI generatif boleh meletup sendiri? Ketahui kajian terkini yang memberi amaran tentang kemerosotannya dan pakar yang menganalisis penyelesaian yang mungkin....Pengarang: Patricia Alegsa

14-10-2024 14:21

Jadual Kandungan

- Amaran Tentang Kemerosotan dalam AI Generatif

- Keruntuhan Model: Fenomena Degeneratif

- Kesukaran Campur Tangan Manusia

- Masa Depan Tidak Pasti: Cabaran dan Penyelesaian Mungkin

Amaran Tentang Kemerosotan dalam AI Generatif

Kajian terkini telah membunyikan amaran mengenai fenomena yang membimbangkan dalam pembangunan kecerdasan buatan generatif: kemerosotan kualiti jawapan.

Pakar telah menunjukkan bahawa apabila sistem ini dilatih dengan data sintetik, iaitu kandungan yang dijana oleh AI lain, ia boleh jatuh ke dalam kitaran kemerosotan yang berakhir dengan jawapan yang tidak masuk akal dan tiada makna.

Soalan yang timbul ialah: bagaimana perkara ini boleh berlaku dan apakah langkah yang boleh diambil untuk mencegahnya?

"Keruntuhan model" merujuk kepada proses di mana sistem AI terperangkap dalam kitaran latihan dengan data berkualiti rendah, yang mengakibatkan kehilangan kepelbagaian dan keberkesanan.

Keruntuhan Model: Fenomena Degeneratif

"Keruntuhan model" merujuk kepada proses di mana sistem AI terperangkap dalam kitaran latihan dengan data berkualiti rendah, yang mengakibatkan kehilangan kepelbagaian dan keberkesanan.

Menurut Ilia Shumailov, pengarang bersama kajian yang diterbitkan dalam Nature, fenomena ini berlaku apabila AI mula memberi makan kepada outputnya sendiri, meneruskan bias dan mengurangkan kegunaannya. Dalam jangka panjang, ini boleh menyebabkan model menghasilkan kandungan yang semakin homogen dan kurang tepat, seperti gema daripada jawapannya sendiri.

Emily Wenger, profesor kejuruteraan di Universiti Duke, menggambarkan masalah ini dengan contoh mudah: jika AI dilatih untuk menjana imej anjing, ia cenderung meniru baka yang paling biasa, mengabaikan yang kurang dikenali.

Emily Wenger, profesor kejuruteraan di Universiti Duke, menggambarkan masalah ini dengan contoh mudah: jika AI dilatih untuk menjana imej anjing, ia cenderung meniru baka yang paling biasa, mengabaikan yang kurang dikenali.

Ini bukan sahaja mencerminkan kualiti data, tetapi juga menimbulkan risiko ketara terhadap perwakilan minoriti dalam set data latihan.

Baca juga: Kecerdasan buatan semakin pintar dan manusia semakin bodoh.

Walaupun situasi ini serius, penyelesaiannya tidak mudah. Shumailov menyatakan bahawa tidak jelas bagaimana untuk mengelakkan keruntuhan model, walaupun terdapat bukti bahawa mencampurkan data sebenar dengan data sintetik boleh mengurangkan kesan tersebut.

Baca juga: Kecerdasan buatan semakin pintar dan manusia semakin bodoh.

Kesukaran Campur Tangan Manusia

Walaupun situasi ini serius, penyelesaiannya tidak mudah. Shumailov menyatakan bahawa tidak jelas bagaimana untuk mengelakkan keruntuhan model, walaupun terdapat bukti bahawa mencampurkan data sebenar dengan data sintetik boleh mengurangkan kesan tersebut.

Namun begitu, ini juga membawa kepada peningkatan kos latihan dan kesukaran yang lebih tinggi untuk mengakses set data lengkap.

Ketiadaan pendekatan jelas untuk campur tangan manusia meninggalkan pembangun dalam dilema: bolehkah manusia benar-benar mengawal masa depan AI generatif?

Fredi Vivas, CEO RockingData, memberi amaran bahawa latihan berlebihan dengan data sintetik boleh mencipta "kesan bilik gema", di mana AI belajar daripada ketidaktepatan sendiri, sekali gus mengurangkan lagi keupayaannya untuk menjana kandungan yang tepat dan pelbagai. Oleh itu, persoalan tentang bagaimana memastikan kualiti dan kegunaan model AI menjadi semakin mendesak.

Masa Depan Tidak Pasti: Cabaran dan Penyelesaian Mungkin

Pakar bersetuju bahawa penggunaan data sintetik tidak semestinya negatif, tetapi pengurusannya memerlukan pendekatan bertanggungjawab. Cadangan seperti pelaksanaan tanda air pada data yang dijana boleh membantu mengenal pasti dan menapis kandungan sintetik, sekaligus memastikan kualiti dalam latihan model AI.

Namun begitu, keberkesanan langkah ini bergantung pada kerjasama antara syarikat teknologi besar dan pembangun model yang lebih kecil.

Masa depan AI generatif sedang dipertaruhkan, dan komuniti saintifik sedang berlumba dengan masa untuk mencari penyelesaian sebelum gelembung kandungan sintetik meletup.

Masa depan AI generatif sedang dipertaruhkan, dan komuniti saintifik sedang berlumba dengan masa untuk mencari penyelesaian sebelum gelembung kandungan sintetik meletup.

Kunci adalah untuk mewujudkan mekanisme kukuh yang memastikan model AI kekal berguna dan tepat, sekaligus mengelakkan keruntuhan yang ditakuti ramai.

Langgan horoskop mingguan percuma

Aquarius Aries Capricorn Gemini Kanser Leo Libra Pisces Sagittarius Skorpio Taurus Virgo

-

Pasangan Australia cukur kepala anak mereka untuk berpura-pura menghidap kanser dan menipu komuniti

Pasangan Australia cukur kepala anak mereka untuk berpura-pura menghidap kanser dan menipu komuniti

Tidak dapat dipercayai! Sepasang suami isteri Australia ditangkap kerana mencukur kepala anak mereka dan berpura-pura menghidap kanser untuk mengumpul wang. Mereka menipu semua orang dan kini berdepan dengan keadilan. -

Anjing Hilang: Bagaimana Mereka Berjaya Menemui Arah dan Pulang ke Rumah?

Anjing Hilang: Bagaimana Mereka Berjaya Menemui Arah dan Pulang ke Rumah?

Anjing hilang: pakar dalam pulang. Mengejutkan, sesetengahnya menemui jalan pulang selepas mengembara berkilometer. Sains masih tertarik. -

Tatu boleh menyebabkan kanser: satu jenis limfoma

Tatu boleh menyebabkan kanser: satu jenis limfoma

Penemuan bahawa tatu boleh meningkatkan risiko limfoma menekankan keperluan untuk lebih banyak penyelidikan dalam bidang ini dan menimbulkan persoalan penting mengenai keselamatan jangka panjang tatu. -

Jaga Otak Anda: Panduan Mencegah Alzheimer dengan Diet dan Tabiat

Jaga Otak Anda: Panduan Mencegah Alzheimer dengan Diet dan Tabiat

Temui cara menjaga otak anda dan mengurangkan risiko Alzheimer dengan panduan lengkap kami mengenai perubahan diet dan tabiat sihat. Mulakan hari ini! -

Jalan Berbahaya Pembedahan Plastik: Menua dengan Maruah

Jalan Berbahaya Pembedahan Plastik: Menua dengan Maruah

Mengapa obsesi terhadap keremajaan boleh menjadikan wajah-wajah terkenal seperti Zac Efron sebagai contoh pembedahan plastik yang gagal. Pelajari cara menua dengan maruah. Jangan lepaskan!

Saya Patricia Alegsa

Saya telah menulis artikel horoskop dan bantuan diri secara profesional selama lebih 20 tahun.

Langgan horoskop mingguan percuma

Terima horoskop mingguan dan artikel baru kami tentang cinta, keluarga, kerja, mimpi dan berita lain terus ke e-mel anda. Kami TIDAK menghantar spam.

Analisis astral dan numerologi

-

Temui masa depan anda, ciri-ciri keperibadian rahsia dan cara untuk memperbaiki diri dalam cinta, perniagaan dan kehidupan secara umum

Temui masa depan anda, ciri-ciri keperibadian rahsia dan cara untuk memperbaiki diri dalam cinta, perniagaan dan kehidupan secara umum

-

Penafsir Mimpi Dalam Talian: dengan kecerdasan buatan

Adakah anda ingin mengetahui maksud sesuatu mimpi yang anda alami? Temui kuasa memahami mimpi anda dengan penafsir mimpi dalam talian kami yang canggih menggunakan kecerdasan buatan yang memberikan jawapan dalam beberapa saat.

Penafsir Mimpi Dalam Talian: dengan kecerdasan buatan

Adakah anda ingin mengetahui maksud sesuatu mimpi yang anda alami? Temui kuasa memahami mimpi anda dengan penafsir mimpi dalam talian kami yang canggih menggunakan kecerdasan buatan yang memberikan jawapan dalam beberapa saat.

-

Video: pemilik kereta ini mempunyai masalah sebenar dengan lebah

Video: pemilik kereta ini mempunyai masalah sebenar dengan lebah

Pemilik kereta yang kita lihat dalam video ini telah menghadapi masalah sebenar: lebah berbahaya telah membuat sarang di situ. -

Hebat! Pedang Ramses II ditemui di Mesir yang bersinar selepas 3,000 tahun

Hebat! Pedang Ramses II ditemui di Mesir yang bersinar selepas 3,000 tahun

Ditemui di Mesir sebuah pedang Ramses II yang bersinar selepas 3,000 tahun. Penemuan yang mengagumkan di sebuah kubu kuno di delta Sungai Nil! -

Cara mematikan Kecerdasan Buatan Google

Cara mematikan Kecerdasan Buatan Google

Enjin carian Google telah mengaktifkan Kecerdasan Buatan mereka, tetapi keputusan yang diberikan boleh mengganggu pengguna. Bagaimana untuk mematikannya? -

Bagaimana rupa watak-watak dalam Friends jika mereka menjadi patung Barbie

Bagaimana rupa watak-watak dalam Friends jika mereka menjadi patung Barbie

Jika anda peminat siri Friends, lihat bagaimana kecerdasan buatan menggambarkan mereka seolah-olah menjadi patung jenis Barbie. -

Cara Menyimpan Avokado: Teknik untuk Menjaga Kesegarannya

Cara Menyimpan Avokado: Teknik untuk Menjaga Kesegarannya

Temui teknik mudah dan berkesan untuk mengekalkan kesegaran buah yang kaya dengan lemak sihat dan vitamin, serta nikmati manfaatnya lebih lama. -

Tajuk:

Ditemui sekumpulan simpanse dengan budaya dan alat seperti manusia

Tajuk:

Ditemui sekumpulan simpanse dengan budaya dan alat seperti manusia

Simpanse di Afrika menunjukkan budaya yang serupa dengan manusia: mereka menggunakan alat dan menyesuaikan kaedah mengikut persekitaran mereka, menunjukkan pemindahan budaya. -

Elon Musk: Neuralink dan Optimus akan mencipta manusia super untuk semua orang

Elon Musk: Neuralink dan Optimus akan mencipta manusia super untuk semua orang

Elon Musk menyatakan bahawa cip Neuralink dan robot Optimus akan mencipta manusia super, meningkatkan kehidupan orang kurang upaya dan memajukan kecerdasan buatan. -

Rempah Mediterranean yang Meningkatkan Kesihatan Anda

Rempah Mediterranean yang Meningkatkan Kesihatan Anda

Temui rempah penting dalam masakan Mediterranean ini, kaya dengan sebatian yang bermanfaat. Mudah masukkan ke dalam diet harian anda dan tingkatkan kesihatan anda! -

Pintu masuk rumah anda dengan Feng Shui: petua untuk menerima tenaga baik dan menghalau getaran buruk

Pintu masuk rumah anda dengan Feng Shui: petua untuk menerima tenaga baik dan menghalau getaran buruk

Temui cara mengaktifkan pintu masuk rumah anda dengan Feng Shui: petua untuk menarik getaran baik, menghalang tenaga negatif dan mencipta pintu masuk yang penuh harmoni. -

Protein dan faktor genetik yang mempengaruhi kesihatan otak

Protein dan faktor genetik yang mempengaruhi kesihatan otak

Ketahui bagaimana protein mempengaruhi komunikasi otak, menyebabkan kematian neuron. Kenali faktor genetik dan gaya hidup yang meningkatkan risiko. -

Apa maksud bermimpi tentang gula-gula?

Apa maksud bermimpi tentang gula-gula?

Temui makna manis di sebalik mimpi anda tentang gula-gula. Adakah ia menunjukkan bahawa anda akan mempunyai kehidupan yang lebih manis atau amaran tentang berlebihan? Baca artikel kami dan ketahuinya! -

Rahsia untuk Kehidupan yang Lebih Bahagia Mengikut Tanda Zodiak Anda

Rahsia untuk Kehidupan yang Lebih Bahagia Mengikut Tanda Zodiak Anda

Ketahui cara menjadi lebih bahagia mengikut tanda zodiak anda! Nasihat peribadi untuk mencapai kebahagiaan! -

Apa maksud bermimpi tentang katak?

Apa maksud bermimpi tentang katak?

Temui makna tersembunyi di sebalik mimpi anda tentang katak. Adakah amfibia hijau ini muncul dalam mimpi anda? Ketahui simbolisme dan nasihat untuk hidup anda.